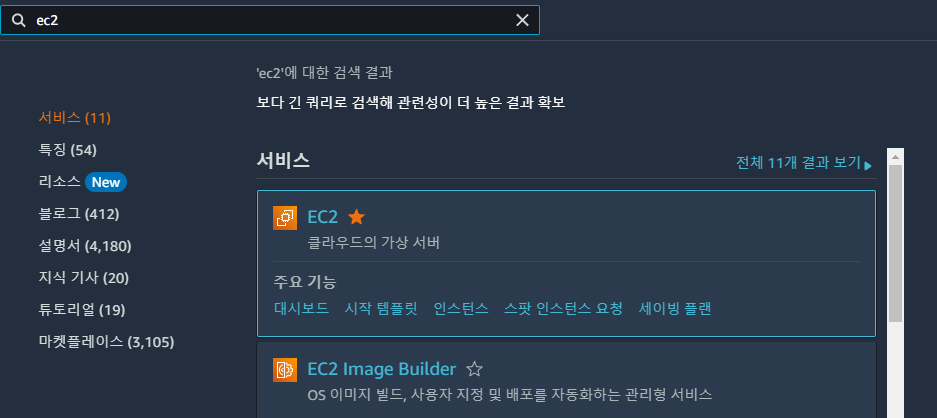

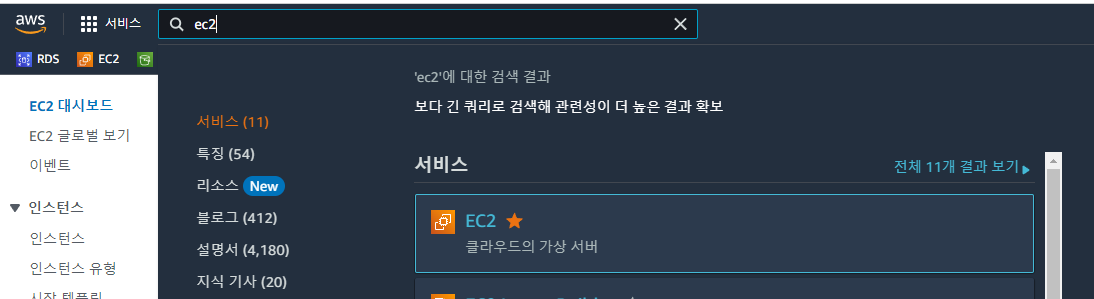

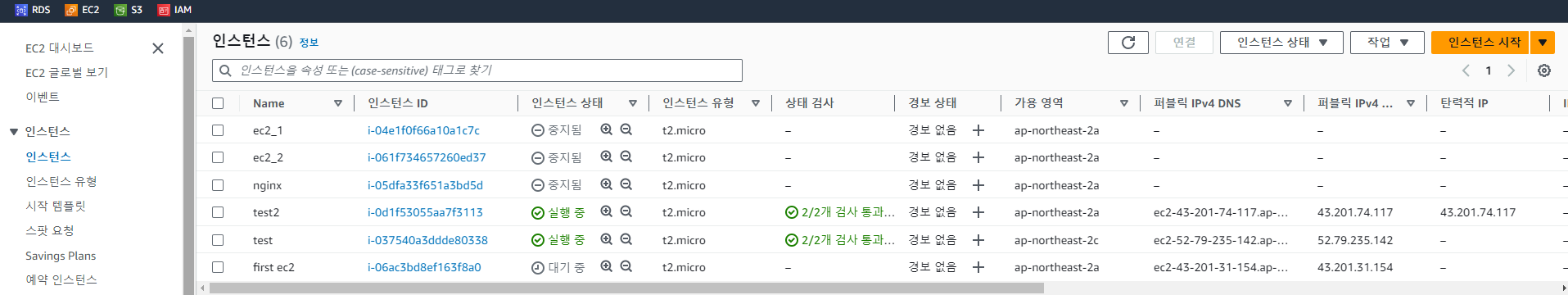

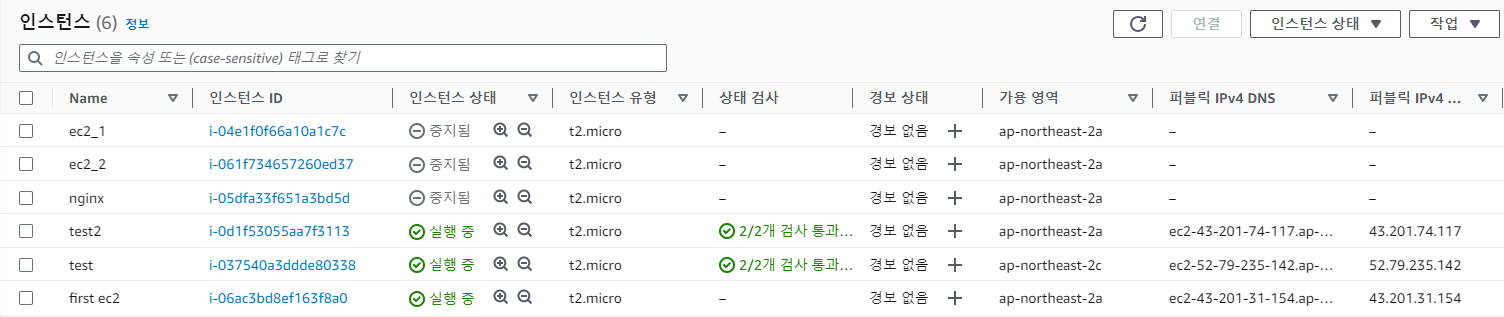

EC2 검색 > 인스턴스

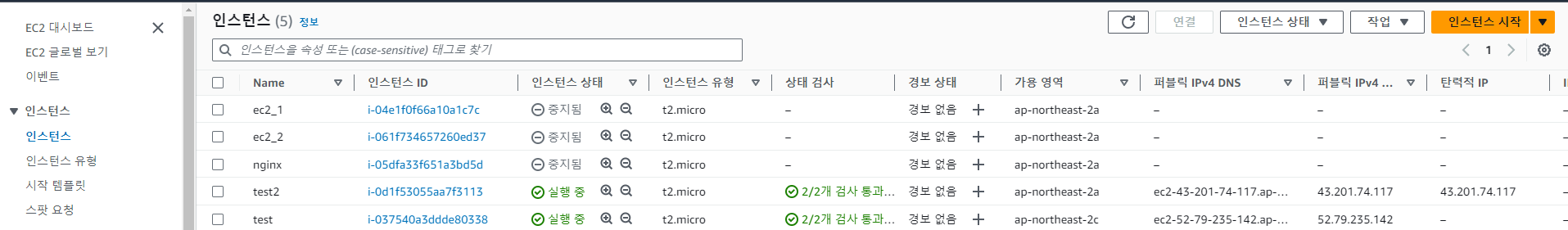

인스턴스 시작 클릭

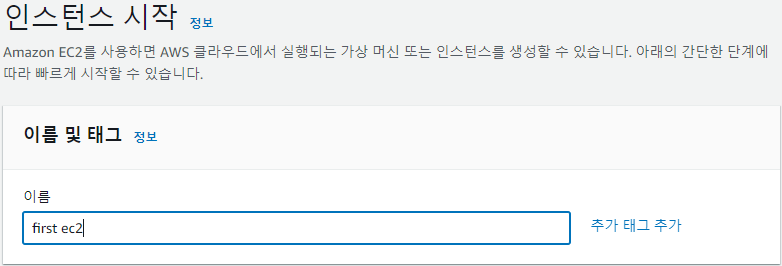

이름 지정

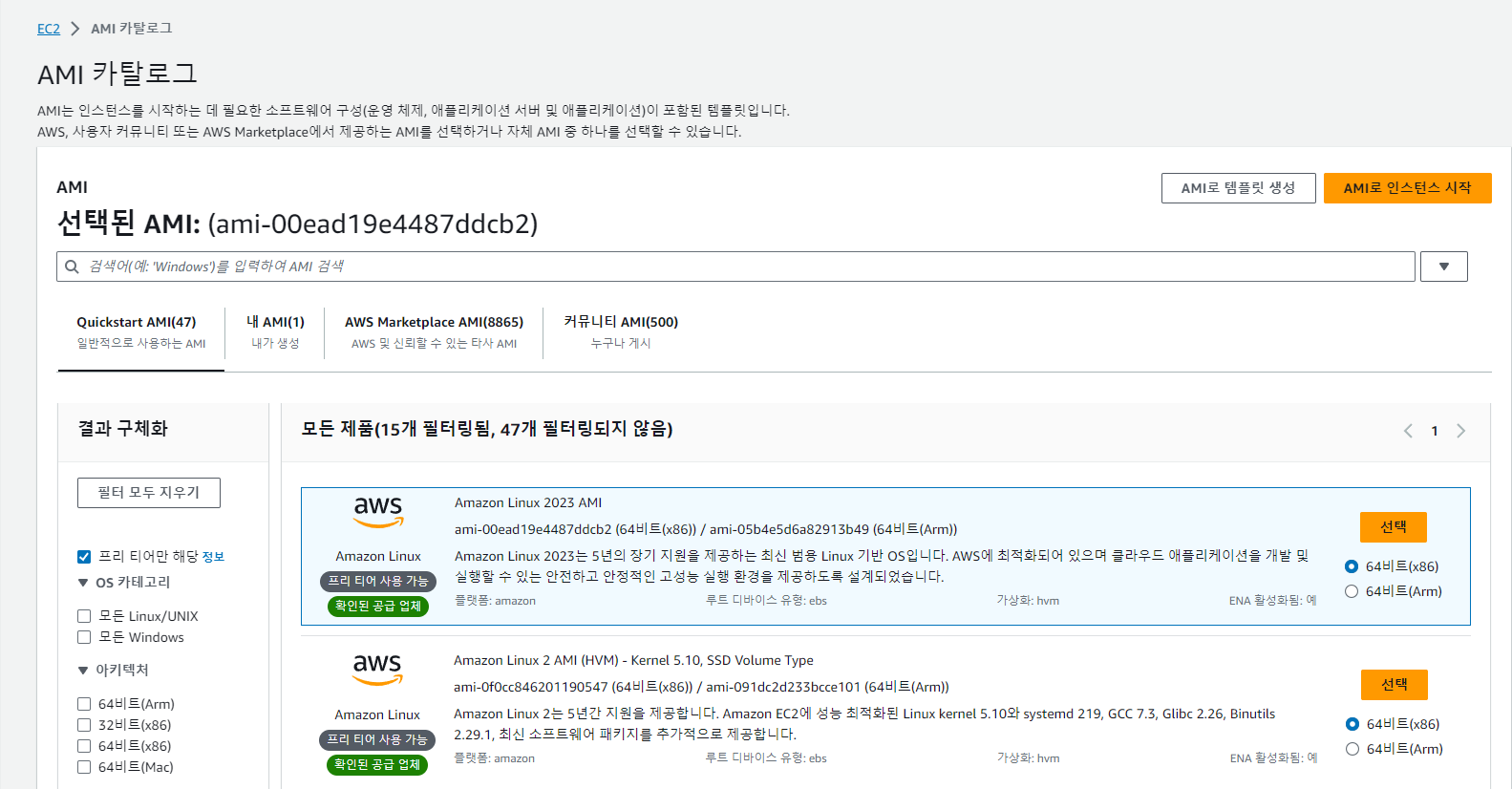

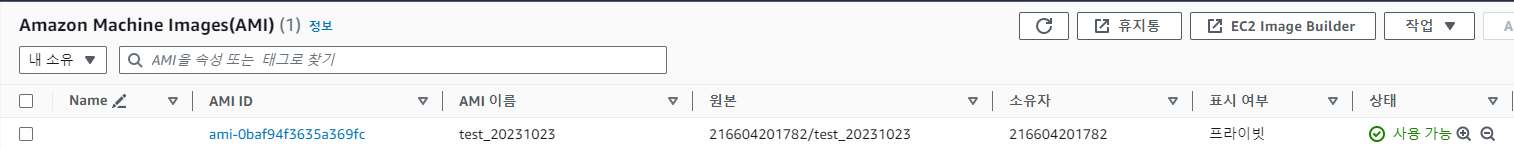

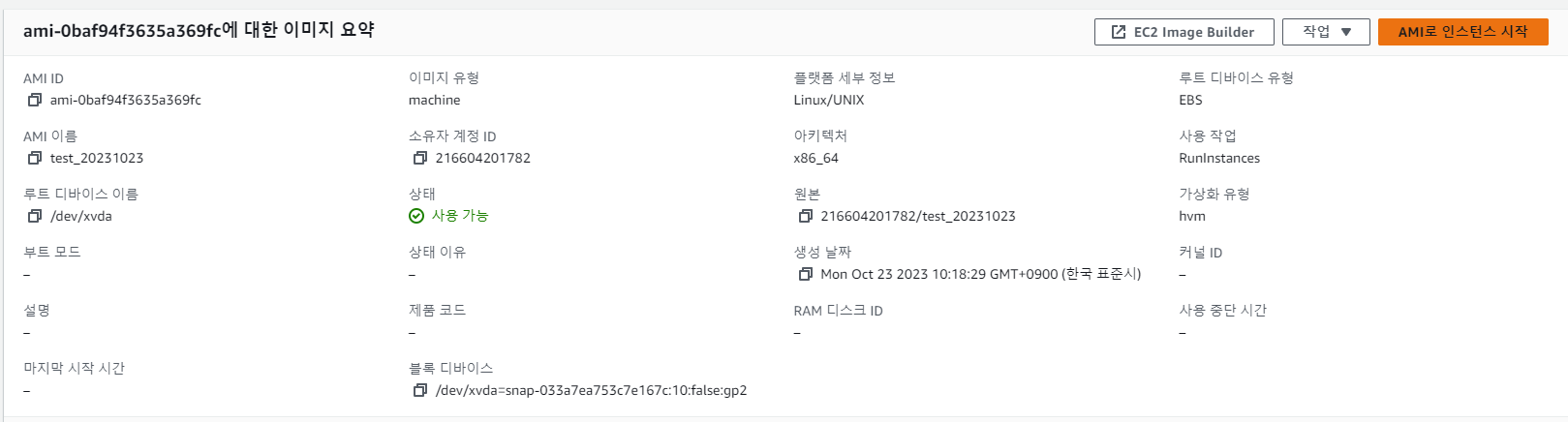

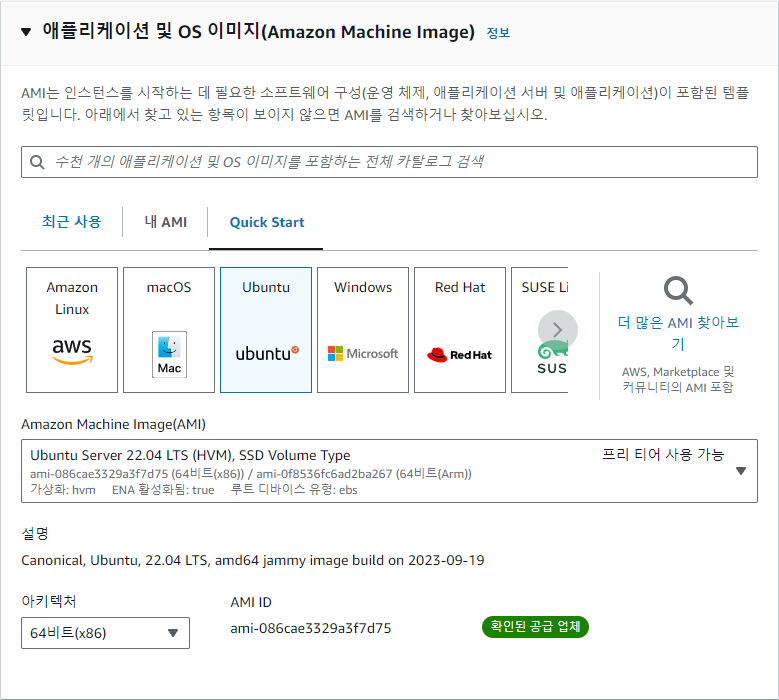

OS 선택 (여기선 ubuntu Server 22.04 LTS )

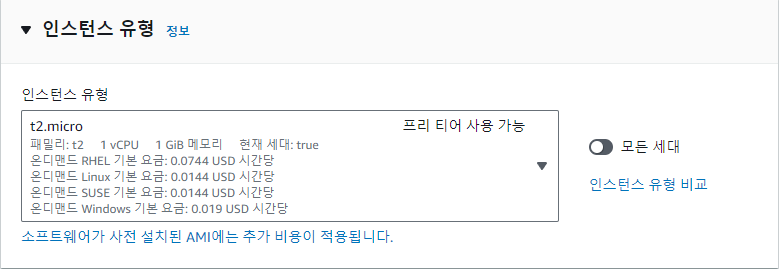

인스턴스 유형 t2.micro

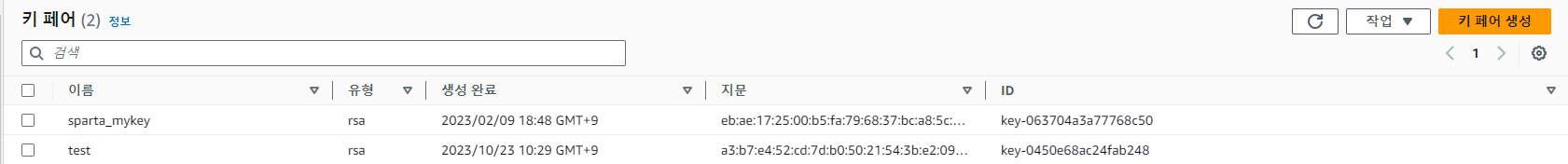

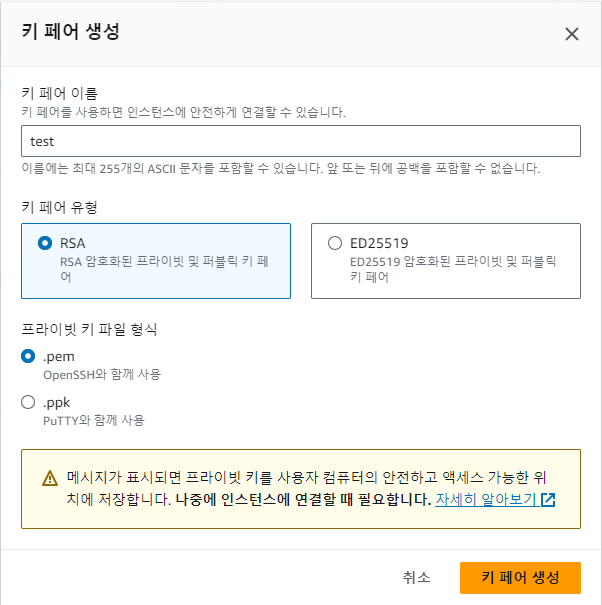

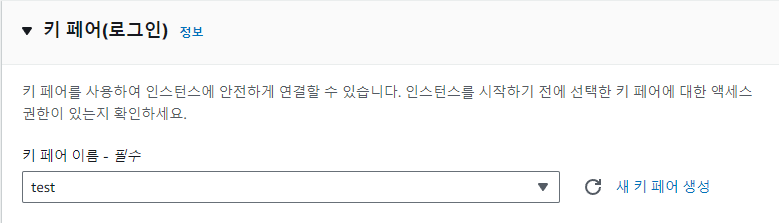

키 페어 선택

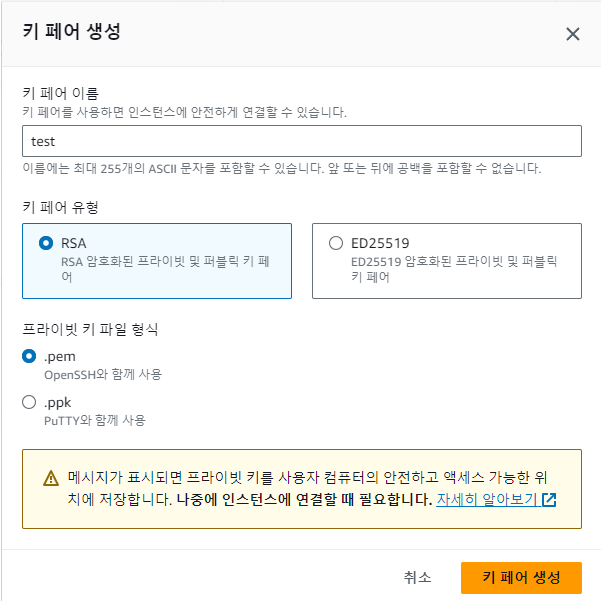

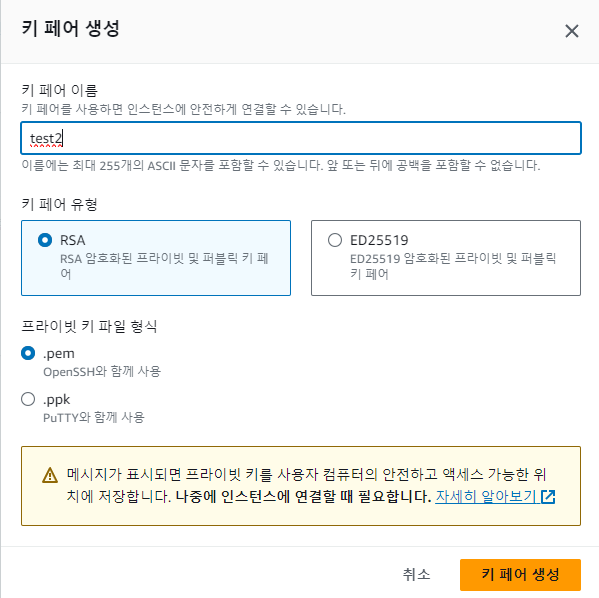

없다면 새 키 페어 생성

.pem으로 생성

putty 사용자라면 .ppk

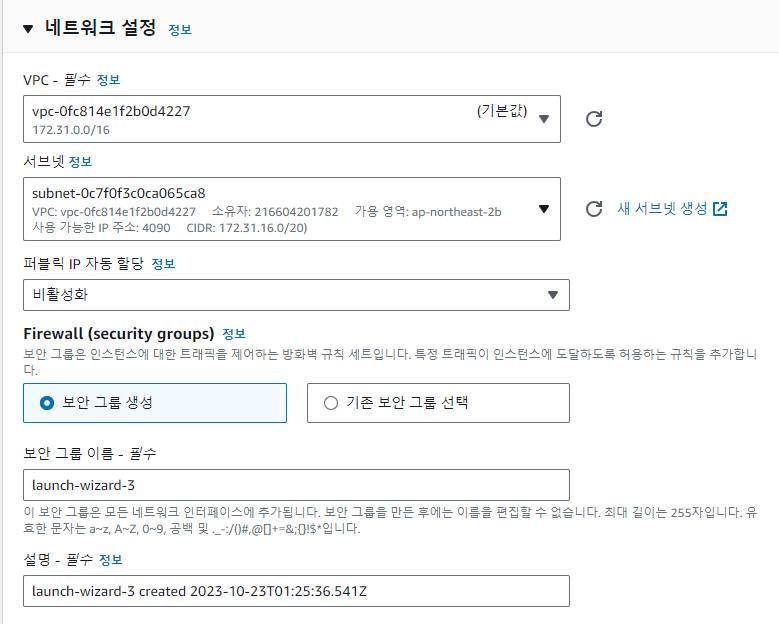

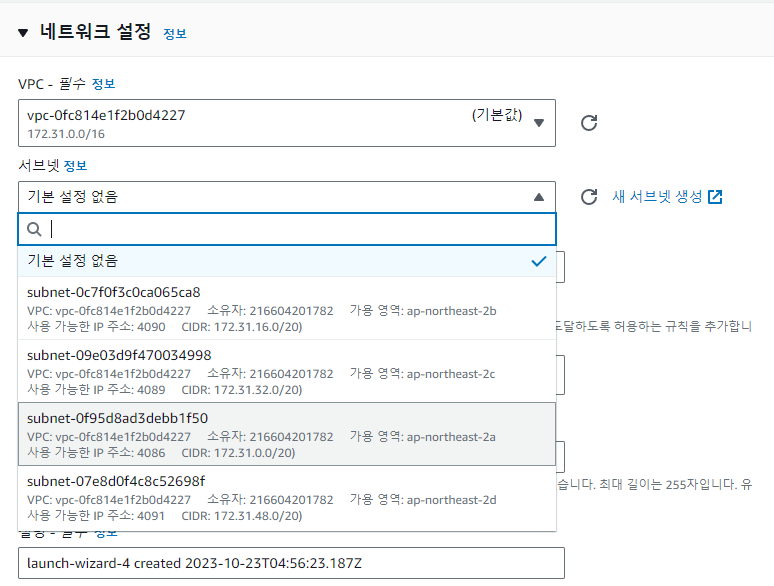

네트워크 설정 > 네트워크 편집

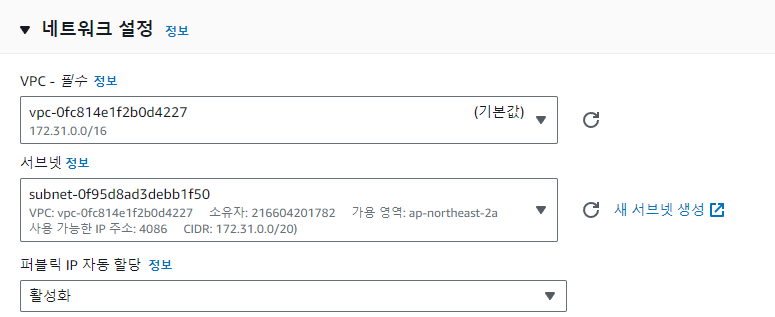

VPC 선택 > 서브넷 선택 여기선 ap-northeast-2a

퍼블릭 IP 자동 할당 ( 탄력적 IP 사용 예정이라면 비활성화)

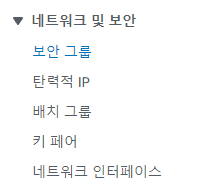

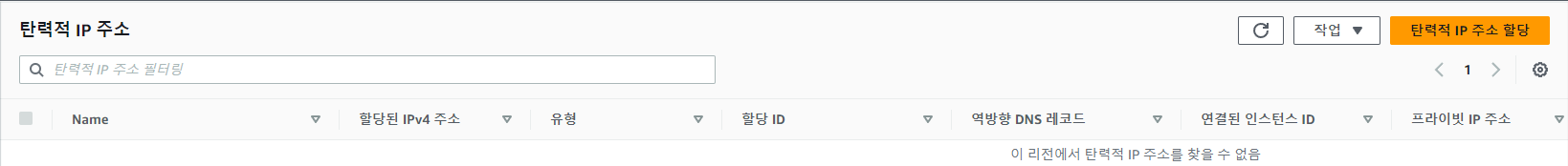

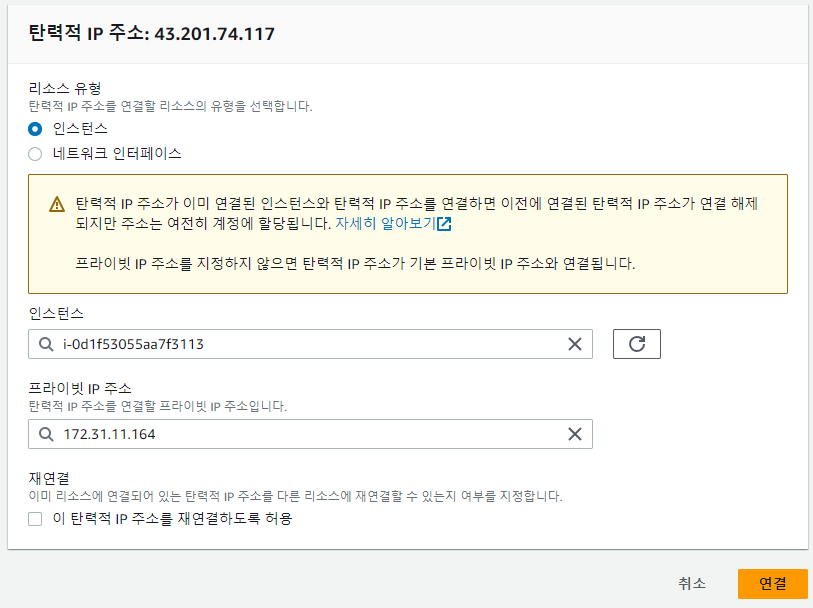

AWS 탄력적 IP 할당 ( 퍼블릭 IP 고정 )

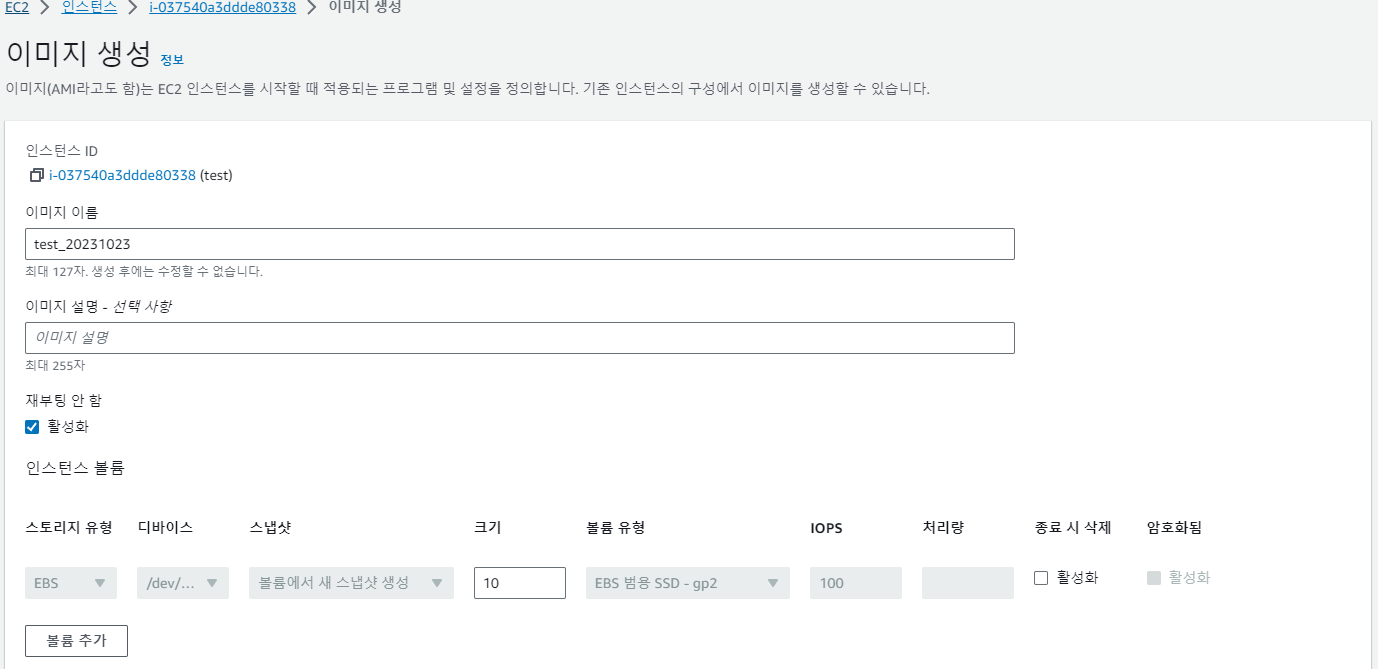

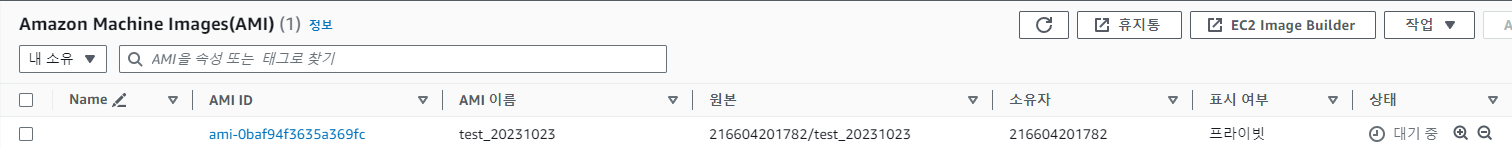

AWS에서 EC2 검색 네트워크 및 보안 > 탄력적 IP 탄력적 IP 주소 할당 네트워크 경계 그룹 ap-northeast-2(서울) 탄력적 IP주소 할당 성공 화면 이전 게시물에서 복사한 test2 인스턴스에 할당 https://yes5.tist

yes5.tistory.com

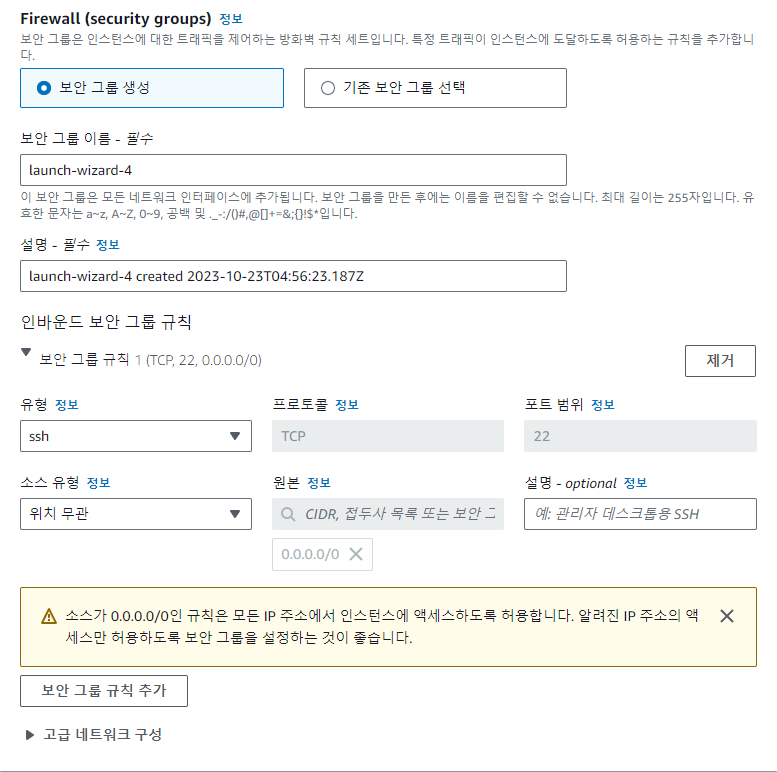

보안 그룹이 이미 있다면 기존 보안 그룹에서 선택

없다면 위와 같이 ssh (22번 port) 0.0.0.0/0으로 열어준다.

자신의 PC 아이피를 안다면 0.0.0.0/0 모든 허용 대신

자신의 아이피/32 허용으로 하는게 더 바람직하다.

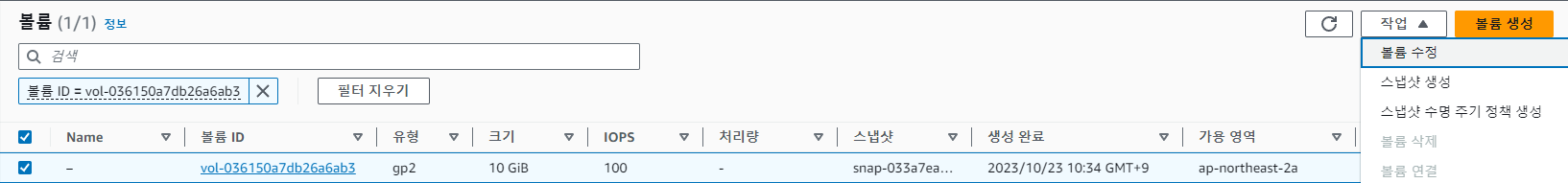

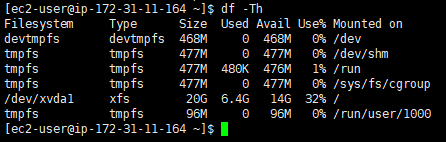

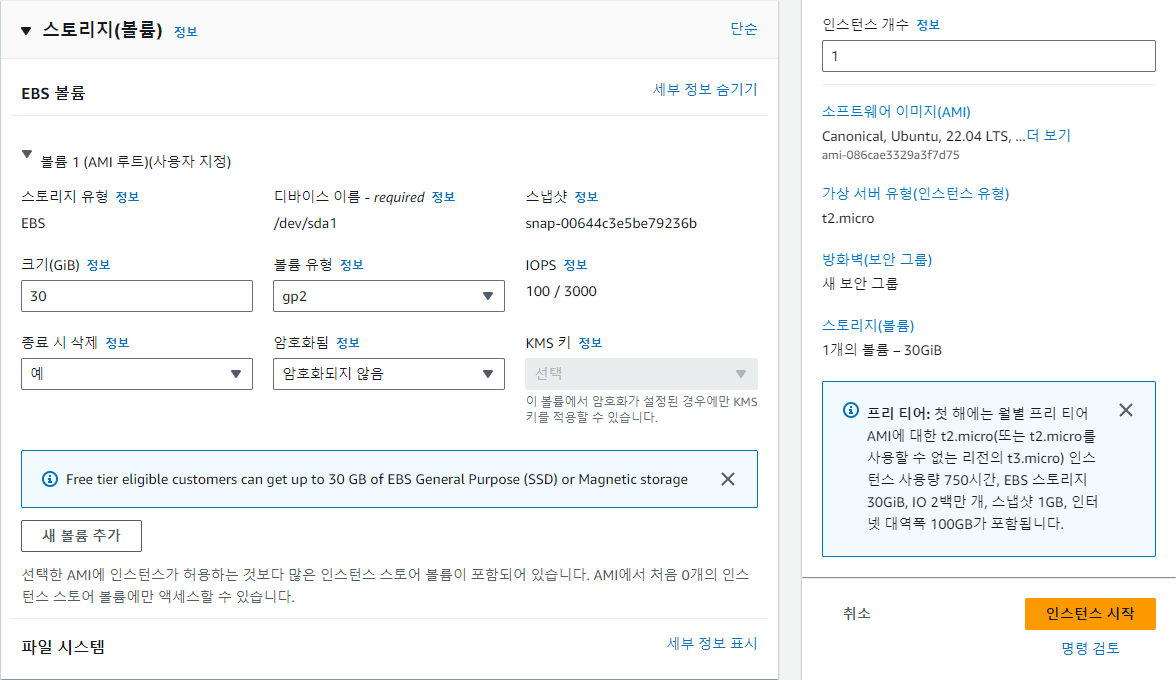

EBS 볼륨크기는 30GB 이하로 알맞게 설정한다.

인스턴스 시작

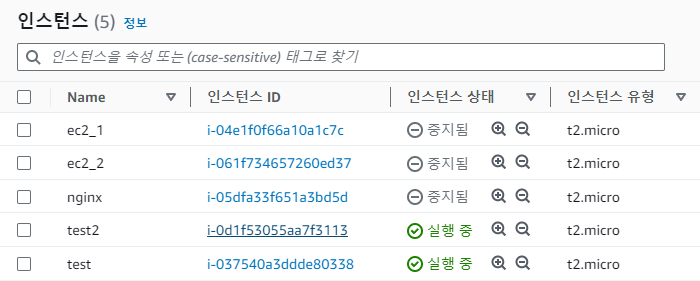

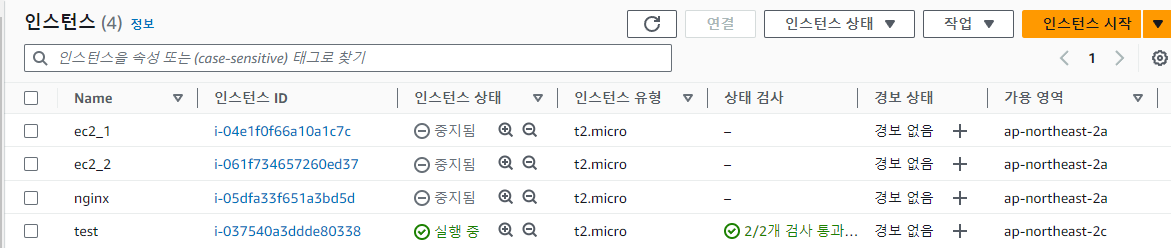

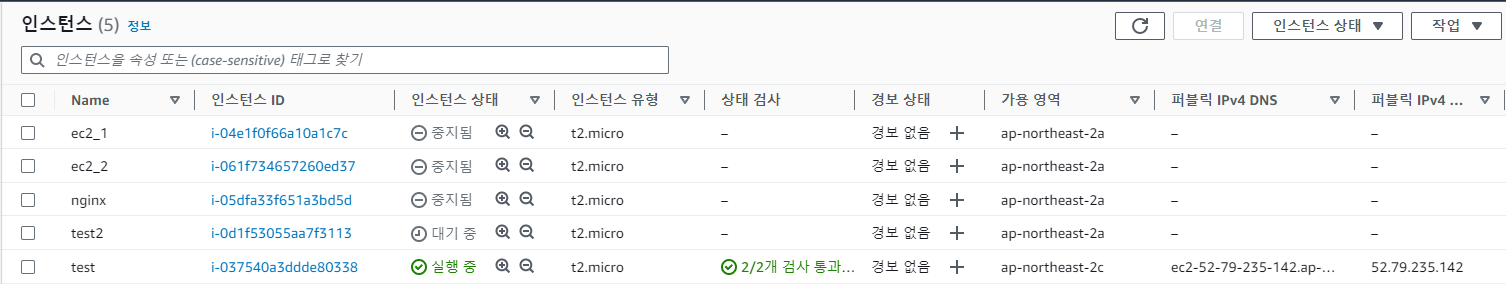

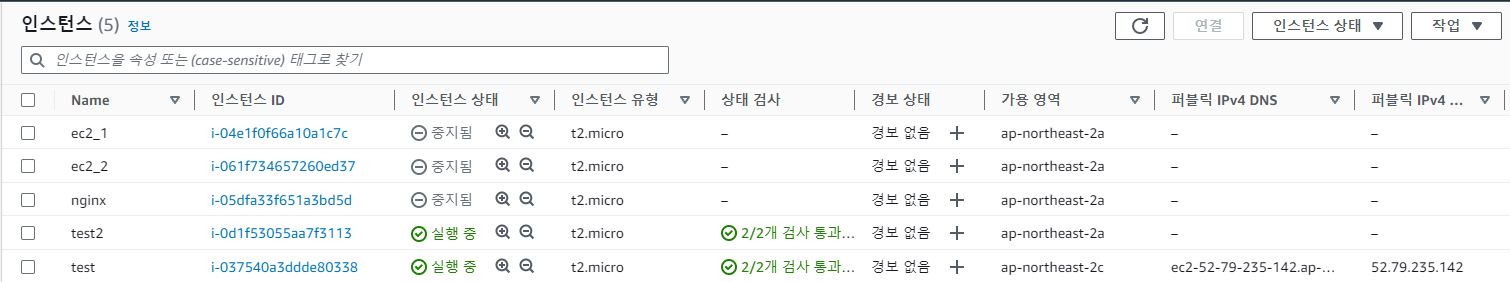

인스턴스 목록에서 first ec2 인스턴스가 생성된 것을 확인.

1~2분 후 대기중 > 실행중으로 변경된 것을 확인.

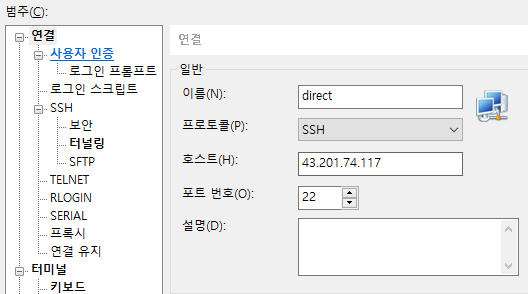

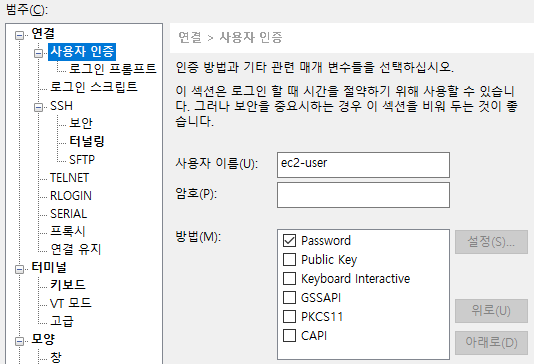

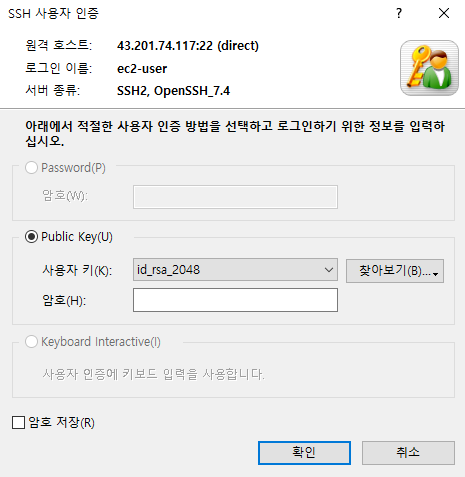

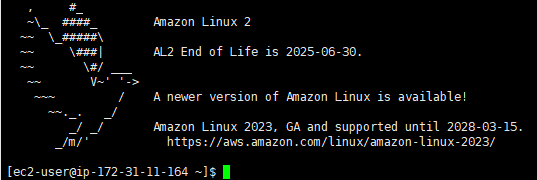

ssh 클라이언트를 이용해 접속 확인을 해보고 싶다면

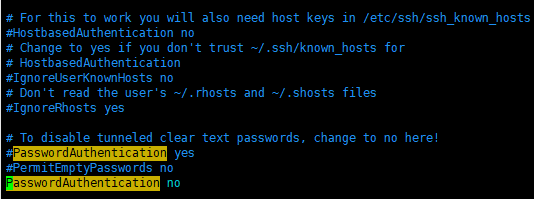

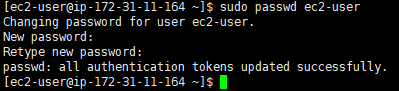

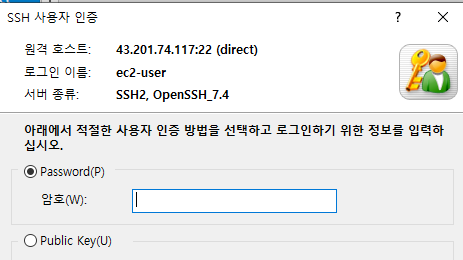

AWS EC2 ssh 비밀번호로 접속

보통 EC2 인스턴스를 생성하거나, 복제할 때 키 페어를 생성 및 선택한다. 혹은 EC2 검색 > 네트워크 및 보안 > 키 페어에서 키 페어 생성 및 수정이 가능하다. ssh client로 xshell 사용자는 .pem putty 사

yes5.tistory.com

'Infra > AWS' 카테고리의 다른 글

| AWS EC2 자동 실행 정지 Lambda 함수 (1) | 2023.10.24 |

|---|---|

| AWS S3 버킷 생성 JS, React 배포, 데이터 백업 (0) | 2023.10.23 |

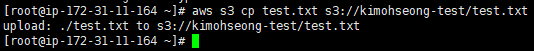

| EC2 - S3 파일 복사 (1) | 2023.10.23 |

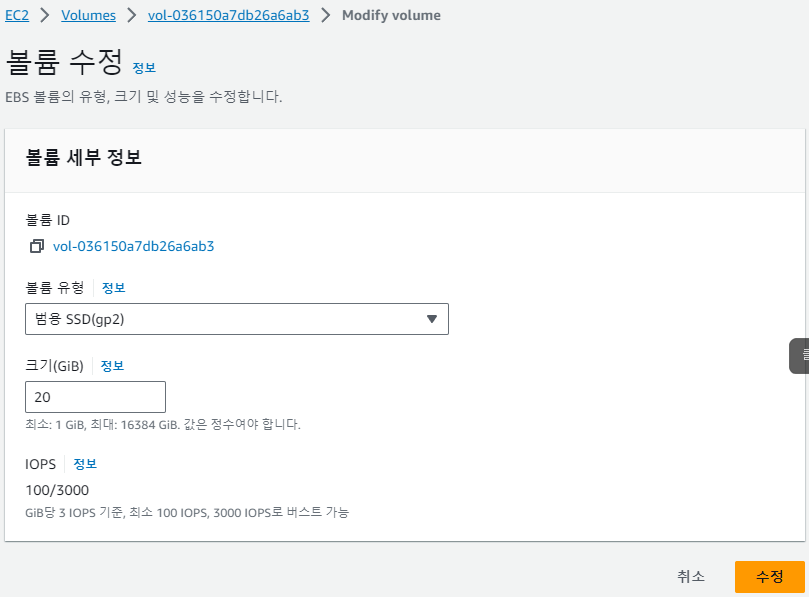

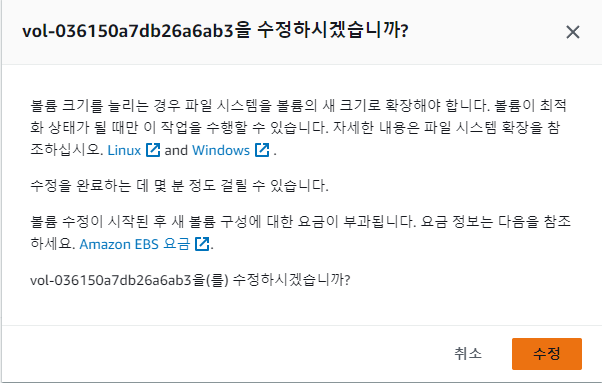

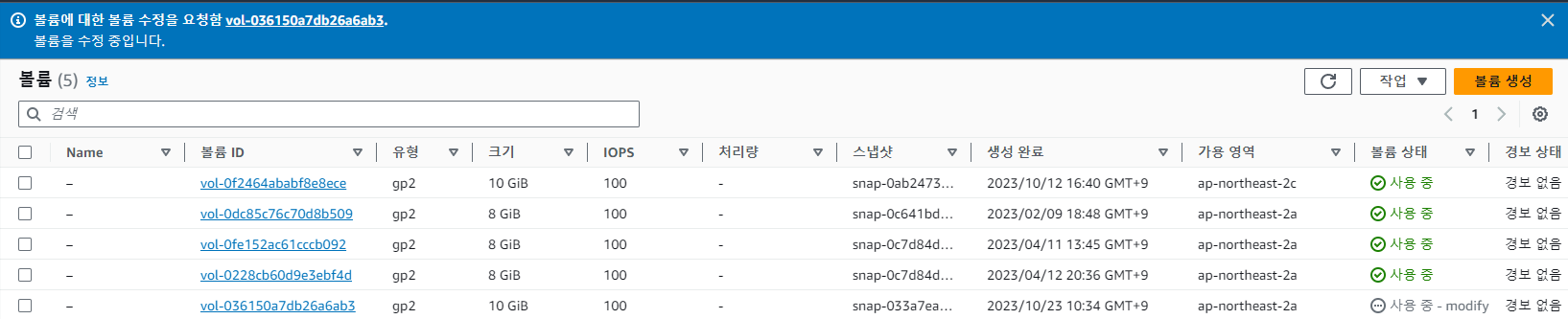

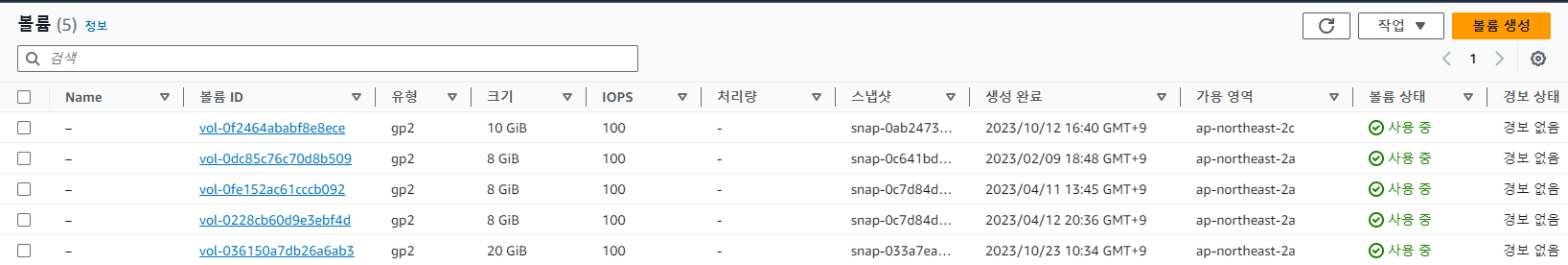

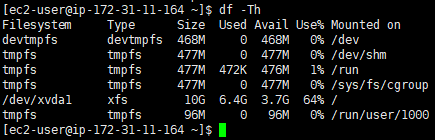

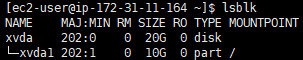

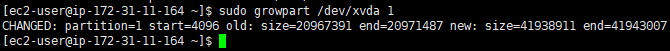

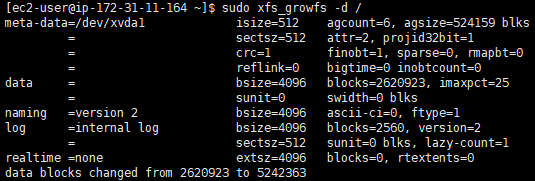

| AWS EC2 용량 추가 (EBS 볼륨 증설) (1) | 2023.10.23 |

| AWS 탄력적 IP 할당 ( 퍼블릭 IP 고정 ) (0) | 2023.10.23 |